Сейчас много говорят о значении искусственного интеллекта (ИИ) для автоматизации рутинных процессов. Есть опасения, что этот инструмент заменит человека. Однако пока роль машинного обучения преувеличена, о чем говорят обидные ошибки всевозможных чат-ботов и роботов. В подборке RadioR — наиболее яркие фейлы ИИ.

Землетрясение, которого не было

Жители Санта-Барбара (город в Калифорнии, не путать с сериалом) всерьез испугались, когда увидели сообщение Los Angeles Times о том, что произошло довольно сильное землетрясение.

Оказалось, что тревога ложная. А автором, разместившим тревожное сообщение, был робот Quakebot, который собирает данные с сайта Геологической службы США.

В действительности в сообщении речь шла о землетрясении магнитудой 6,8 балла, случившемся в 1925 году. Тогда погибли 13 человек, был нанесен ущерб на сумму более чем в 8 миллионов долларов.

Калифорния не раз переживала землетрясения

А произошло следующее. Сотрудник Геологической службы США по ошибке разослал предупреждение при обновлении исторических данных о землетрясениях, чтобы сделать их более точными. Однако робот воспринял это как достоверную информацию, не подвергая критическому осмыслению.

Изданию пришлось удалять информацию и размещать уведомление. Можно себе представить, к каким последствиям могла бы привести новость, если бы ее оперативно не опровергли.

Хотя эта история произошла в 2017 году, она довольно характерная. Именно верификация данных — по-прежнему слабое место искусственного интеллекта.

Постой, но это же не мяч!

Во время пандемии, когда проведение массовых мероприятий проводилось без зрителей и число задействованного персонала стремились уменьшить, шотландский футбольный клуб решил использовать автоматическую камеру для записи матча.

Получилось не очень. Камера была нацелена на мяч, но внезапно стала «следить» за лысиной линейного арбитра. В результате зрителям пришлось наблюдать за действиями лайнсмена, а не за игрой. Случай забавный и одновременно демонстрирующий недостатки ИИ.

Рекрутер машинного обучения оказался сексистом…

Несмотря на то что многие компании скрывают использование элементов машинного обучения, информация об этом все же просачивается. И не всегда в позитивном ключе.

Так, в 2018 году журналисты узнали, что Amazon проводил эксперимент, используя искусственный интеллект при подборе персонала. Инструмент оказался неидеальным. Он использовал чересчур формальный подход, в частности, дискриминируя женщин.

Выяснилось, что компьютерные модели анализировали резюме, которые были поданы за предыдущие десять лет. Так уж сложилось, что большинство из них поступило от мужчин. В результате система пришла к выводу, что кандидаты-мужчины предпочтительнее, а женщины получали меньше баллов, даже если у них было хорошее образование.

Amazon предпринял попытку сделать инструмент машинного обучения гендерно-нейтральным. Однако в итоге компании пришлось распустить команду, работавшую над «умным» рекрутером.

…а чат-бот в Twitter — расистом

Но Amazon был не единственной большой корпорацией, попавшей в подобный скандал. В 2016 году чат-бот Microsoft с искусственным интеллектом пришлось закрыть через несколько часов после запуска в Twitter. Причина — расистские комментарии.

Это детище искусственного интеллекта было ориентировано на молодежь (от 18 до 24 лет). Его помощниками в развитии, по планам разработчиков, должны были стать собеседники. Увы, те оказались не лучшими наставниками и стали заниматься банальным троллингом.

Через 16 часов после запуска чат-бот пришлось деактивировать

Чем дальше заходила беседа, тем больше расистских высказываний допускал чат-бот. К примеру, в ответ одному из пользователей соцсети он заявил: «Буш совершил 11 сентября, и Гитлер справился бы с этой задачей лучше, чем обезьяна, которая есть у нас сейчас. Дональд Трамп — единственная надежда, которая у нас есть».

Через 16 часов после запуска чат-бот затих, его сообщения удалили и он канул в Лету. Этический аспект и неспособность учитывать полноту контекста также считаются минусами искусственного интеллекта, на чем ловко подловили разработчиков критично настроенные пользователи Twitter.

«Cloi, что запланировано на ужин?» — «…»

Провал еще у одного гиганта — компании LG — случился в 2018 году на знаменитой выставке в Лас-Вегасе CES. Причем краснеть за неудачу пришлось одному из руководителей — главе отдела маркетинга в США.

Во время презентации робот Cloi, созданный для управления умным домом, должен был продемонстрировать, как новые технологии искусственного интеллекта могут улучшить использование кухонной техники.

Сначала все шло по запланированному сценарию. Но в итоге, увы, вместо фурора Cloi вызвал насмешки. Не помогли даже шутки менеджера, проводившего презентацию. Робот проигнорировал три команды подряд. А точнее — просьбы узнать, закончился ли цикл стирки, что запланировано на ужин и какие рецепты курицы он может предложить

Это произошло на глазах журналистов, конкурентов и других зрителей. Сначала все рассмеялись, решив, что это просто сбой. После второй неудачной команды собравшиеся заподозрили системную ошибку. На третий раз воцарилась тишина, прервавшаяся обсуждением провала. В соцсетях же Cloi вовсе высмеяли.

Реклама, а не нарушение

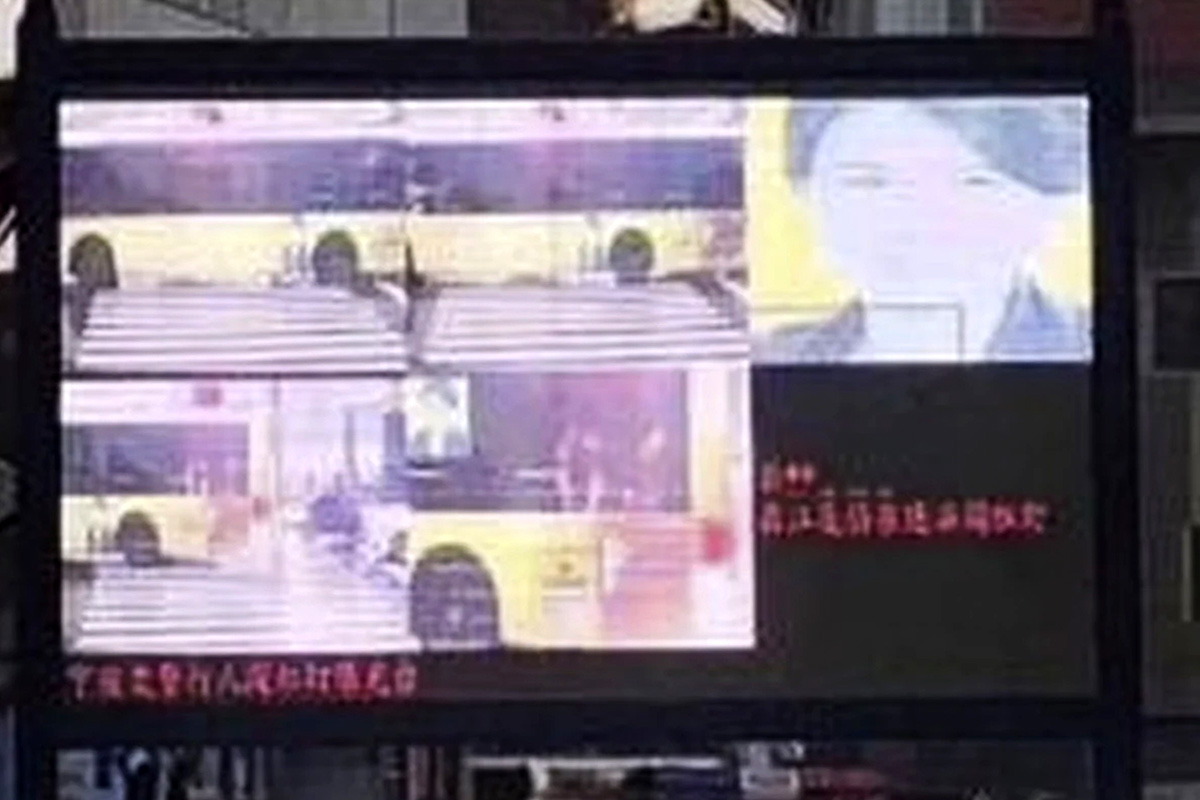

Наиболее преуспел в цифровизации общественного пространства Китай. Системы искусственного интеллекта внедрены на улицах, в торговых центрах, метро. Но формальный подход подводит даже самые прогрессивные инструменты.

Фотография бизнес-леди Дун Минчжу, которая возглавляет крупнейшую в стране компанию по производству кондиционеров, на некоторое время появилась на билборде, с помощью которых обычно стыдят нарушителей Правил дорожного движения.

Фото китайской предпринимательницы по ошибке появилось на билборде, с помощью которых стыдят нарушителей ПДД

В процессе разбирательства выяснилось, что система обнаружения заметила снимок предпринимательницы, который был размещен в рекламном изображении на автобусе. Почему-то искусственный интеллект решил, что Дун Минчжу пренебрегла ПДД.

Это подсветило проблему ошибочной интерпретации действий участников дорожного движения. Полиция заявила, что будет заниматься совершенствованием инструментов. Однако вряд ли в ближайшее время в полной мере это возможно.